Publicado el: 14/04/2025

OpenAI lanza GPT-4.1, Mini y Nano: tres modelos que redibujan el mapa del desarrollo con IA

Más rápidos, más inteligentes, más accesibles... y solo para desarrolladores API

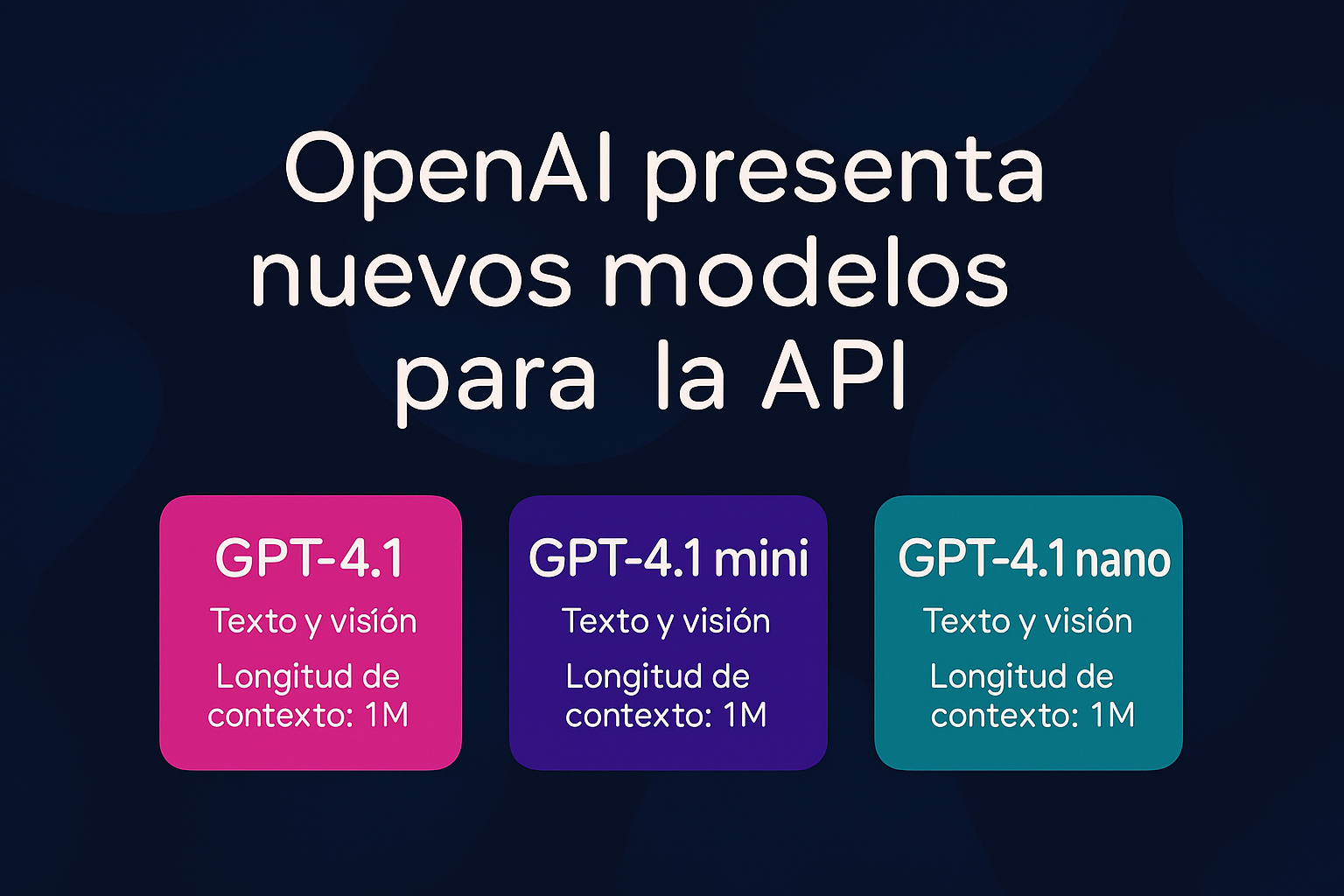

OpenAI ha anunciado oficialmente la nueva familia de modelos GPT-4.1, diseñada exclusivamente para quienes trabajan con la API. Se trata de un hito en la evolución de modelos de lenguaje por su balance entre rendimiento, coste y capacidad de contexto extendido: por primera vez, incluso su modelo más básico, GPT-4.1 Nano, permite trabajar con ventanas de hasta 1 millón de tokens.

Este lanzamiento no solo representa una mejora incremental sobre GPT-4.0: lo supera ampliamente en múltiples áreas, alcanza o incluso sobrepasa a GPT-4.5 en varios benchmarks, y redefine cómo los desarrolladores pueden integrar IA en productos reales.

Una familia de tres modelos, para cada tipo de proyecto

GPT-4.1

El modelo más potente de OpenAI hasta la fecha, destinado a tareas complejas que requieren razonamiento profundo, codificación avanzada y seguimiento estricto de instrucciones.

- Contexto: Hasta 1 millón de tokens.

- Precio: $2 por millón de tokens de entrada y $8 por salida.

- Ideal para: productos intensivos en inteligencia, desarrollos empresariales avanzados, analítica de datos a gran escala.

GPT-4.1 Mini

El equilibrio perfecto entre velocidad, coste e inteligencia. Sorprende por su capacidad de comprensión multimodal y su rendimiento superior al esperado para tareas interactivas.

- Precio: $0.40 entrada / $1.60 salida.

- Ventana de contexto: 1M tokens.

- Ideal para: herramientas internas, agentes inteligentes, asistentes virtuales robustos.

GPT-4.1 Nano

El modelo más rápido y económico jamás lanzado por OpenAI, pensado para tareas ligeras, respuestas veloces y procesamiento simple a gran escala.

- Precio: $0.10 entrada / $0.40 salida.

- Ideal para: autocompletado, extracción de texto, clasificación masiva de datos, análisis de logs.

Qué cambia con respecto a GPT-4.0 y 4.5

El salto no es menor. GPT-4.1 no solo mejora la capacidad de razonamiento, sino que reduce la verbosidad en las respuestas, acelera el tiempo de respuesta, y es más preciso incluso cuando se trabaja con instrucciones estrictas, formatos estructurados (como XML) o interacciones multi-turno.

Entre los aspectos más destacados:

- Precisión en SWE-bench: 55%, frente al 33% anterior con GPT-4.0.

- Reducción de respuestas innecesarias: hasta 50% menos verbosidad.

- Capacidad para "seguir reglas estrictas": como detectar si un input cumple con etiquetas específicas antes de responder.

- Mejor comprensión visual: rendimiento sobresaliente en el benchmark MME (72%).

Uno de los aspectos más impresionantes es que todos los modelos, incluyendo Nano, pueden realizar tareas que antes requerían arquitecturas más costosas y complejas, como buscar patrones en archivos de más de 450.000 tokens o generar interfaces web funcionales desde una sola petición.

Una revolución en el uso del contexto largo

El contexto de un millón de tokens deja de ser una promesa para convertirse en un estándar accesible. Para validarlo, OpenAI ha ejecutado pruebas como "needle-in-a-haystack", donde los modelos deben detectar datos escondidos en medio de extensos textos. Todos los modelos respondieron con precisión, incluso en tareas que implicaban mantener el hilo de instrucciones que aparecieron muchas interacciones atrás.

Además, OpenAI presentó OpenAI MRCR, una evaluación pública que pone a prueba el seguimiento de instrucciones en conversaciones largas y anidadas, replicando casos reales de interacción prolongada. GPT-4.1 muestra mejoras notables en memoria contextual, incluso frente a modelos de mayor coste como GPT-4.5.

¿Qué significa esto para los desarrolladores?

La familia GPT-4.1 no solo mejora capacidades, sino que reduce drásticamente los costes. La estructura de precios es hasta un 80% más baja que la de modelos anteriores, sin renunciar a capacidades avanzadas como seguimiento de instrucciones, generación de código, comprensión de imágenes o contexto largo. A esto se suma un acceso inmediato a través de la API, sin aumentos de precio por usar la ventana larga.

Esto allana el camino para la creación de agentes, herramientas internas, productos SaaS o integraciones sectoriales más accesibles que nunca.

¿Y para empresas que trabajan con IA aplicada?

Desde Sphere lo vemos claro: este lanzamiento refuerza una tendencia que ya habíamos detectado desde Utilia en muchos de nuestros proyectos con clientes en Gran Canaria y otros puntos de España. Gracias a la evolución de modelos como estos, podemos ofrecer soluciones modulares, escalables y adaptadas a cada nivel de madurez digital —como lo hacemos con nuestro ecosistema Lumin— sin depender de una infraestructura cara o compleja.

La llegada de GPT-4.1 Mini y Nano, con precios ajustados y alto rendimiento, habilita escenarios antes imposibles: desde automatización contable en despachos medianos hasta asistentes educativos personalizados para formación interna o modelos que resuelven consultas de usuarios sobre normativa sin intervención humana directa.

Un paso firme hacia una IA más accesible y estratégica

OpenAI ha confirmado que estos nuevos modelos estarán disponibles solo por API, y que en los próximos meses se iniciará la retirada de GPT-4.5 para optimizar el uso de recursos (GPUs). La estrategia está clara: simplificar el catálogo, reforzar el rendimiento, y abaratar el acceso a la inteligencia artificial de alta calidad.

Desde Utilia lo celebramos. Esto significa que el desarrollo real de soluciones con IA entra en una etapa nueva, más madura y sostenible. Y por supuesto, estaremos aquí para ayudar a traducir estas novedades en impacto tangible para cada negocio, cada equipo, cada profesional que apueste por aprovechar esta tecnología.